Se han identificado más de 30 vulnerabilidades de seguridad en varios modelos de inteligencia artificial (IA) y aprendizaje automático (ML) de código abierto, algunas de las cuales podrían permitir la ejecución remota de código y el robo de datos.

Estas fallas, encontradas en herramientas como ChuanhuChatGPT, Lunary y LocalAI, fueron reportadas a través de la plataforma de recompensas por errores Huntr de Protect AI.

Entre los defectos más graves, se destacan dos vulnerabilidades en Lunary, un conjunto de herramientas para modelos de lenguaje grandes (LLM):

- CVE-2024-7474 (CVSS: 9,1): Esta vulnerabilidad de referencia directa a objetos insegura (IDOR) podría permitir que un usuario autenticado acceda o elimine usuarios externos, lo que resulta en acceso no autorizado a datos.

- CVE-2024-7475 (CVSS: 9,1): Una deficiencia de control de acceso que permite a un atacante modificar la configuración de SAML, facilitando el acceso como un usuario no autorizado.

Además, se encontró otra vulnerabilidad IDOR en Lunary (CVE-2024-7473, CVSS: 7,5) que permite a un atacante actualizar los mensajes de otros usuarios manipulando un parámetro controlado por el usuario.

Protect AI explicó: “Un atacante puede iniciar sesión como Usuario A e interceptar una solicitud para actualizar un mensaje. Al cambiar el parámetro ‘id’ por el ‘id’ de un mensaje del Usuario B, puede actualizar el mensaje del Usuario B sin autorización”.

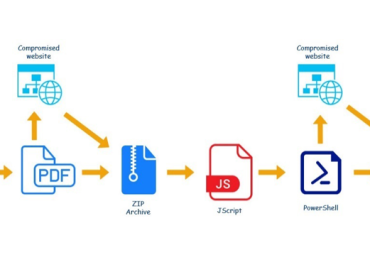

Otra vulnerabilidad crítica se refiere a un error de recorrido de ruta en la función de carga de usuarios de ChuanhuChatGPT (CVE-2024-5982, CVSS: 9,1) que podría llevar a la ejecución de código arbitrario y la exposición de datos confidenciales.

Se identificaron dos fallos de seguridad en LocalAI, un proyecto que permite ejecutar LLM autohospedados. Estas vulnerabilidades podrían permitir a actores maliciosos ejecutar código arbitrario al cargar un archivo de configuración malicioso (CVE-2024-6983, CVSS: 8,8) y adivinar claves API válidas analizando el tiempo de respuesta del servidor (CVE-2024-7010, CVSS: 7,5).

Protect AI comentó: “La vulnerabilidad permite a un atacante realizar un ataque de sincronización, un tipo de ataque de canal lateral. Al medir el tiempo de procesamiento de solicitudes con diferentes claves API, el atacante puede inferir la clave correcta carácter por carácter”.

También se detectó una falla de ejecución remota de código en Deep Java Library (CVE-2024-8396, CVSS: 7,8) que se origina en un error de sobrescritura de archivos en la función de descompresión del paquete.

Este descubrimiento llega tras los parches lanzados por NVIDIA para corregir una vulnerabilidad en su marco de IA generativa NeMo (CVE-2024-0129, CVSS: 6,3) que podría permitir la ejecución de código y la manipulación de datos.

Se recomienda a los usuarios actualizar a las últimas versiones para proteger sus sistemas de IA/ML y evitar posibles ataques.

La divulgación de estas vulnerabilidades sigue al lanzamiento de Vulnhuntr por Protect AI, un analizador de código estático de Python que utiliza LLM para detectar vulnerabilidades de día cero.

Vulnhuntr divide el código en fragmentos más pequeños, evitando saturar la ventana de contexto del LLM, para identificar problemas de seguridad.

“Busca automáticamente en los archivos del proyecto aquellos que procesan la entrada del usuario y luego ingiere todo el archivo para identificar vulnerabilidades potenciales”, explicaron los desarrolladores.

Por último, una nueva técnica de jailbreak descubierta por 0Day Investigative Network (0Din) revela que mensajes maliciosos codificados en hexadecimal y emojis podrían eludir las salvaguardas de OpenAI ChatGPT.

Marco Figueroa, investigador de seguridad, indicó: “Esta táctica explota una laguna lingüística al pedir al modelo que realice una tarea aparentemente inofensiva, como la conversión hexadecimal. El modelo, diseñado para seguir instrucciones en lenguaje natural, no detecta que esta conversión puede resultar dañina”.

Esta debilidad se origina en el hecho de que el modelo sigue instrucciones paso a paso sin un entendimiento profundo del contexto para evaluar la seguridad de cada acción dentro de un objetivo mayor.

Fuente: thehackernews.com